直近の検索アルゴリズムアップデート

Googleのアップデートに関する履歴については、Google Search ranking updatesのページからも確認できます。急な順位変動のあった場合の確認のために、ブックマークしておくと良いかもしれません。

March 2025 Core Update

2025年最初のコアアップデートはの3月13日に実施され、3月27日に完了しています。全世界をすべての言語を対象としています。

December 2024 スパムアップデート

2024年の12月19日にアップデートを実施し、約二週間経過して2024年12月26日に更新が完了しています。すべての言語と地域に影響します。

December 2024 Core Update

2024年の12月12日に2024年で4回目のコアアップデートが開始され、12月18日に完了しました。前の週にアップデートが完了したばかりとなります。アップデートが連続した理由としては、今回は異なるコアシステムを対象としているからのようです。

2024年12月13日、Googleはスイス・チューリッヒで開催された「Google Search Central Live」イベントにて、今後コアアップデート(Core Update)をより頻繁に実施する方針を発表しました。これまで年に3〜4回程度だったコアアップデートが、今後はより短い間隔で行われる可能性があります。

November 2024 Core Update

2024年11月11日に2024年で3回目のコアアップデートが開始され、12月5日に完了しています。

August 2024 コアアップデート

8月15日に開始され、1ヶ月間続くと予想されていたロールアウトは、9月3日に早々に終了しました。アップデートは全世界を対象としていて、Google DiscoverやAIの概要、強調スニペットにも影響します。

今回のアップデートは以下のような人の役に立つコンテンツを持つ小規模および独立系のパブリッシャーの順位改善が期待されます。

- 検索エンジンだけの順位改善を目的したコンテンツがほとんどない

- 検索クエリの意図と関連性が高く、オリジナルで役に立つコンテンツを持つ

2023年9月にHCU(ヘルプフルコンテンツアップデート)に打撃を受けたサイトがようやく回復しつつあります。

Google Search Centralもコアアップデートに関するドキュメントを更新し、以下の項目を追加しました:

📑 検索順位の下落を分析する際に役立つ指針で、内容を自己評価するための3つの質問も用意されています。

📑変更を加えるためのヒント:

- SEOのアドバイスだけですぐに修正するのは避けましょう。

- リライトやセクションの追加など、ユーザーフレンドリーな改善に重点を置きましょう。

- ユーザ向けではなく、SEOのために作られた場合のみ、コンテンツを削除しましょう。

結果はさまざまで、すぐに変化が現れる場合もあれば、数ヶ月かかる場合もあります。変化が見られない場合は、次のアップデートをお待ちください。

June 2024 スパムアップデート

2024年6月20日に新たなスパムアップデートを実施し、6月27日に完了しています。

影響を受けてしまったサイトはGoogleのポリシーに沿って運営する必要があります。また、ポリシーに沿って運営したとしても、Googleはスパムアップデートを定期的に更新するため、元の状態に戻るには何ヶ月もかかってしまうようです。

SEOに取り組み初めたばかりの場合は誰でも検索順位変動に一喜一憂してしまいがちです。確かに折角作成したコンテンツの順位が落ちてしまったら、誰でも不安になり、その原因を調べたくなってしまうものです。

結論を先に言ってしまえば、200以上のシグナルをもとに複合的に判断するアルゴリズムの動きは複雑で、実際に順位が落ちた原因を断定する事はできません。

このような場合に、すぐに順位が元に戻るような魔法のようなテクニックというものはなく、結局ウェブサイトやコンテンツの使いやすさや品質をユーザー目線で改善していくしかありません。

ここでは、推測される順位変動要因と、順位変動に対する心構えについて解説します。

突然下降するGoogleの検索順位変動要因

既に作成したコンテンツがGoogleに評価されて上位表示されても、突然順位が下降することがあります。以下の要因をチェックしておきましょう。

ウェブサイトの設定ミスや影響の強い要素の変更

ウェブサイトの設定で考えられるミスとしては、次のようなものがあります。

- サイトリニューアル時の301リダイレクト忘れ

- ナビゲーションメニューを含むデザインの大幅な変更

- Search ConsoleのURL削除ツールを誤って使用してしまった

Search ConsoleのURLパラメータを誤って使用した

※URLパラメータツールは2022年4月に廃止されました- noindexを誤って設定した

- canonicalを誤って設定した

- 重要なタイトル文を変更してしまった

- URLを変更してしまった

- ページを削除してしまった

- ページ上に表示される日付に関して誤った設定を行ってしまった

これらは原因として考えられる一部の例で他にも順位に影響する要素はたくさんあるはずです。ウェブサイトの設定に関するミスの疑いがある場合には、一ヶ月以内で行った作業を確認し、設定ミスなどがないか確認しましょう。

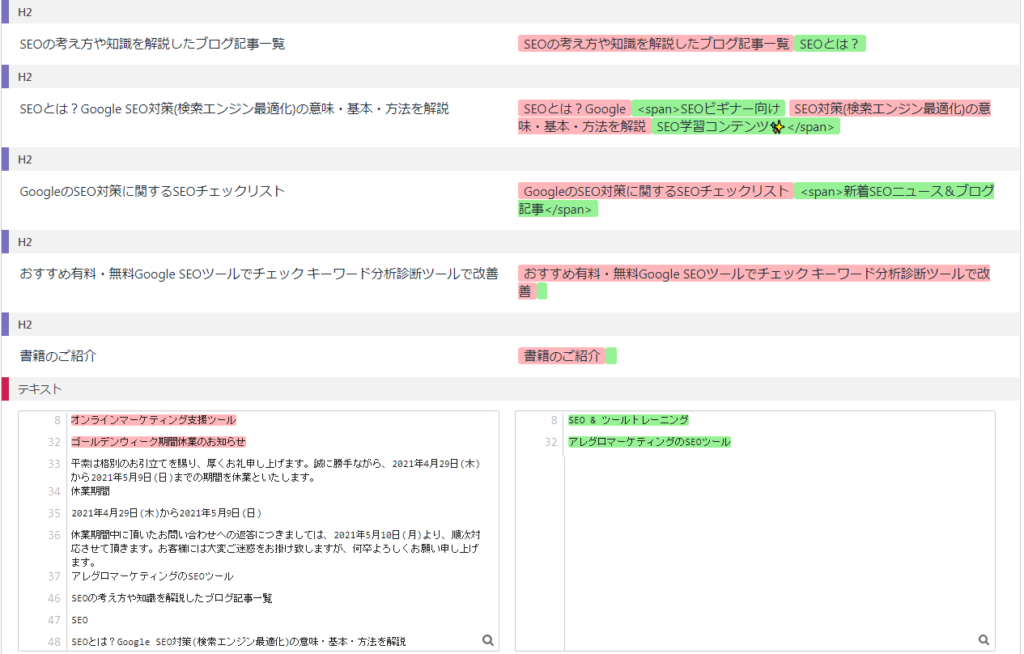

問題点を突き止める場合には、SE Ranking のサイトSEO検査が便利です。

このツールを使って以下の手順で問題点を抽出する事ができます。

SE Ranking では14日間ご利用頂ける無料トライアルアカウントを作成できます。

アカウントを作成すると、自動的にプロジェクト作成手順が示されます。以下の導入手順に沿って必要な項目を入力しましょう。

しばらくするとサイトSEO検査が完了します。左メニューの「サイトSEO検査」内のサブセクションの「問題点」レポートをクリックして、「エラー」タブをクリックしエラーの内容を確認しましょう。

「説明」をクリックすると、チェック項目の内容と修正方法を確認する事ができます。

ページ列の番号部分をクリックすると、該当するページを確認する事ができます。

ガイドライン違反となるスパム行為

ガイドライン違反となるようなスパム行為を行ってしまった場合、それが意図的であろうがなかろうがウェブサイトの評価を傷つける結果となります。

Googleはスパム行為に対しては、アルゴリズムと手動による対策の2つの方法で対応しています。

- 手動による対策

-

手動による対策とは、ガイドラインに違反する行為に対して、Googleのスタッフが直接対策する事を意味します。

ウェブサイトやページの評価を下げ、またはインデックスから削除されて検索結果に表示されなくなってしまう事もあります。

Googleがスパムを見つける場合には、以下のURLからの第三者によるスパムレポートがきっかけとなる事もあります。手動による対策の数は、労力もかかる為、少ないように思われるかもしれませんが、Googleの報告によると450,000件を超える月が少なくとも3回あります。

2016年に900万通、2017年は600万通を超えるウェブスパムに関するメッセージを送信しているようです。

同じ2017年の実績としては、Googleは約90,000件の検索スパムに関するユーザーレポートを処理したと報告されています。また、ハッキングされたウェブサイトのうち80%以上を検知して検索から除外する事ができるようです。

手動による対策が行われているか確認する場合には、Search Consoleの左メニュー内の「検索トラフィック」⇒「手動による対策」をクリックします。

手動によるウェブスパム対策は見つかりませんでした。と表示されていれば問題ありませんので、何もする必要はありません。

手動による対策が行われている場合には、表示されているメッセージに従ってガイドライン違反となる要因を排除し、Googleに再審査リクエストを行います。

- アルゴリズムによる対策

-

アルゴリズムによる対策は、プログラムによって自動でスパム行為を検知し、ウェブサイトやページの評価を下げ、または、無効化したりなどの対策が行われます。

手動によるスパムと異なり、メッセージが通知される事はありませんので、原因を特定することは難しいでしょう。疑わしい場合には、ガイドラインを再確認し、過去に行った違反行為も含めて全て排除しましょう。

ガイドライン違反やスパム行為といったやましい事を行っていなければ、全く心配する必要はありません。(通常のウェブサイト運営者であれば気にする必要はないでしょう。)

手動による対策やアルゴリズムによる対策の基準となる、品質に関するガイドラインについては、以下のページをご参照ください。

ガイドラインを見てもいまいち良くわからない場合は、SEOに対する取り組み方そのものが誤っている場合があります。「GoogleのSEO対策の基本をわかりやすく解説」の記事をご覧頂ければ正しいSEOの取り組み方をご理解頂けるかもしれません。

また、アルゴリズムに関する大きなアップデートに関しては、Googleから公式のアナウンスがあります。「Google 検索セントラル ブログ」を確認しておくと良いでしょう。

セキュリティの問題

ウェブサイトがセキュリティの脅威にさらされている場合、検索ユーザーがそのページ、またはウェブサイトに移動する直前に警告を表示する事があります。この場合、検索トラフィックが減少します。

アルゴリズムの変更

SEOの順位計測が可能なSERPチェッカーを使って複数サイト登録していれば、全体的に順位が変動していることがつかめるかもしれません。

※SERP(Search Engine Result Page)はサープと読み、検索結果ページの事を意味します。

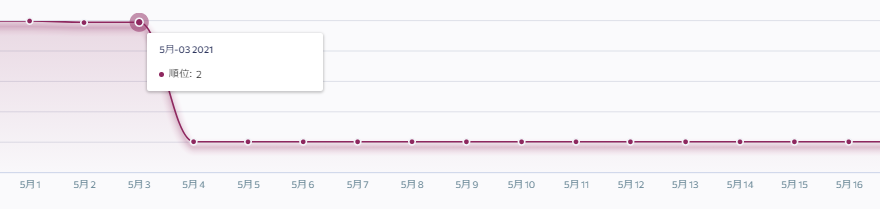

SE Rankingを活用されている場合には、検索順位セクションでアルゴリズムのアップデート情報も確認できます。

アルゴリズムのアップデートの場合には、余程大きな修正でない限りはGoogleからのアナウンスはありません。仮に順位が下降してしまったとしても、このような事は当然起こりうるものとして認識しなければなりません。

アナウンスのないアルゴリズムのアップデートに関して、そのランキング要因を突き止めて対策するという事はほぼ不可能です。

Googleはユーザーを第一に考え、利便性の高い検索エンジンとなるように日々改良しています。

ウェブサイト運営者も同じベクトルで、検索ユーザーにとって価値のあるコンテンツを提供し、利便性を改善するように心がけましょう。この場合に出来ることはそれ以外に多くはありません。

Googleのアルゴリズム

主要なGoogleの検索アルゴリズムを以下にまとめています。それぞれの特徴を見ていくことでGoogleの方針を理解することができます。

徐々に下降するGoogleの検索順位変動要因

上位表示後に時間の経過と様々な外部環境の変化により、徐々に順位は下降していきます。以下の点を定期的にチェックしましょう。

ライバルコンテンツの出現

SEOを意識してコンテンツを作成しているのは、当然自分だけではありません。既存のライバルコンテンツの品質が改善された場合や、新たなウェブサイト運営者によって品質の高いコンテンツが作成された場合には、全体の順位に影響してくるでしょう。

ライバルコンテンツを確認したうえで、それ以上の品質となるようにコンテンツのリライトを行うか、対抗できる新たなコンテンツを作成する事を心がけましょう。

SE Rankingを使用すれば重要な競合の順位を監視するだけでなく、対象キーワードの上位100位の検索結果を過去に遡って追跡する事もできます。

※キーワードを追加した後から現在までの履歴を確認できます。

SE Rankingでは、警戒が必要な競合サイトのコンテンツを監視する事もできます。SE Rankingのページ変更検知は、自身のサイトの重要ページで発生する思わぬ変更点を検知するツールです。

このツールを以下の手順で競合監視に使用する事も可能です。

- 競合サイトのプロジェクトを一つ作成

- サイトSEO検査内を表示

- サブセクションの「ページ変更検知」をクリック

- 監視対象の競合URLを登録

ページ変更検知ツールのメリット

- SEO目的のページ修正を検知して前後を比較

- 価格の変更や、新製品の情報などを素早く検知

- チェック頻度は毎日、毎週、毎月を指定でき、曜日や時間も指定可能

- 変更があった場合にはEメールで通知される

ユーザーの意図が変化してきた

一度特定のクエリで上位表示されたコンテンツであっても、時間とともにユーザーの調べたい意図は変化してきます。

上位表示されているライバルコンテンツの傾向や、検索ユーザーが疑問に思っている事を調べ、現在の検索ユーザーの意図にマッチするようにコンテンツをリライトしましょう。

検索ユーザーが疑問に思っている事を調べる際には、ターゲットとするクエリのサジェストキーワードを調べて見ましょう。以下のようなサービスはユーザーの意図をリサーチする際に便利です。

- キーワードサジェストリサーチツール

※キーワードボリュームとサジェスト両方を抽出 - Googleキーワードプランナー

- ラッコキーワード

- Yahoo!知恵袋

これらのツールは、SEOのクエリ選定の際にユーザーの使用するクエリを調査する目的でも使用します。

コンテンツの情報が古くなってしまった

一度作成したコンテンツでも、1年以上経てば外部の環境も異なってきて、情報も古くなってしまいます。外部の環境の変化に左右されない、または変化がほとんどない普遍的な情報も当然ありますが、例えばWindowsのOSに関する記事や、ウェブの技術に関する記事に関しては情報の移り変わりが激しい為、すぐに情報が古くなってしまいがちです。

Googleは情報の鮮度が重要視されるクエリに関しては、QDFというアルゴリズムが影響して新しい情報を掲載しているコンテンツを優遇します。

作成したコンテンツを放置していた為に、ランキングが落ちてきてしまっている場合には、最新の情報を加えて再編集して改善しましょう。

Analyzing Google Search traffic drops

I think the trending graphic that was added to the blog post about analyzing traffic drops could have looked like this too. Maybe it didn’t make the cut. 🙂 pic.twitter.com/iJWRefHapX

— Glenn Gabe (@glenngabe) July 20, 2021

新規コンテンツ公開直後の順位変動の理由

コンテンツの信頼性は、獲得したリンクや、ウェブサイト全体で公開しているコンテンツの質など、様々な要素で判断されていると推測されます。

新しいページでコンテンツを作成した際には、利用できる情報が限られている中で最善の推測にもとづいて判断しなければなりません。Googleからするとそのコンテンツが本当に信頼できるものかどうかすぐには判断できないようです。その為順位が不安定になる事があるようです。その後更に情報が増えれば統合し、突然本来の検索順位に落ち着きます。

その他のケースでは、情報の鮮度を評価するQDFアルゴリズムが作用している事もあります。また、いくつかのクエリでは、そのコンテンツの特性で長い間上位に表示されるものもあります。

John Muller氏も2017/10/20に同様の発言をしています。ページ公開直後は評価する為のシグナルが多くない為、複数回に渡ってコンテンツを見て、適正な順位を決めているようです。

ウェブサイトの品質によっても公開当初の順位は変化する

John Mueller氏のコメントによると、Googleが既にそのウェブサイトの事を知っている場合、品質が高く、良いコンテンツを持ち、ユーザーとの関連性があるウェブサイトであれば、新しいページの内容が(その時点で)わからなくても、おそらく問題ないはずだと判断する。

一方でスパムのようで、品質の低いウェブサイトが、新しいページを追加した場合には、最初の順位付けに関して注意深く扱うようです。

順位変動で一喜一憂してしまうと、落ち着いてコンテンツを作成できません。

順位は気になりますが気にしすぎても精神面で不健康になります。そもそもライバルよりも圧倒的に優れたコンテンツを提供できていない限りは、順位は安定しません。

順位が上がっても、下がっても、変化しなくても、常に検索ユーザーに対して誰よりも優れた体験を提供できるように改善していく事が最も大切です。Googleと同じように、ユーザー第一の心構えでウェブサイトを運営していきましょう。